Toujours variés, toujours en lien avec l’actualité technique et sociétale, les “ateliers du deuxième jour” font la part belle à l’appliqué, aux retours d’expérience et à l’échange. Selon la vocation première de Teratec, ils mettent également l’accent sur les enjeux industriels découlant des technologies abordées. En voici une description complète, pour vous donner envie…

• Systèmes complexes, mécatroniques et embarqués

• La simulation numérique des matériaux

• Big Data et HPC

• 5ème journée des utilisateurs Scilab

• HPC et efficacité énergétique

• Le HPC dans la Santé

• Modélisation et simulation au service de la ville durable

Systèmes complexes, mécatroniques et embarqués

(Amphi 1 – Mercredi 26 juin de 9h00 à 13h00)

Thème récurrent du Forum Teratec, cet atelier incontournable renouvellera cette année son panorama détaillé de l’état de l’art des technologies, méthodes et outils de conception des systèmes complexes, en particulier dans l’embarqué.

Techniquement, les systèmes embarqués présentent en effet des défis majeurs pour les ingénieurs, dans la mesure où ils concentrent l’essentiel des difficultés rencontrées sur les systèmes classiques – haute performance et haute fiabilité, notamment – en y ajoutant leurs contraintes propres. Hautement intéressant, donc, ce sujet s’inscrit par ailleurs dans un contexte de demande en forte croissance. Aux secteurs traditionnellement concernés (spatial, aéronautique, automobile, énergie…) s’ajoutent en effet de nouveaux entrants (multimédia, e-santé…), qui voient dans de tels systèmes des horizons technologiques prometteurs.

L’intérêt de cet atelier, généralement très fréquenté, réside en particulier dans l’expression de la vision stratégique de grands laboratoires de recherche, d’industriels pionniers dans leurs domaines, mais également de fournisseurs des technologies matérielles et logicielles qui constituent les briques de base avec lesquelles chacun travaille.

Les débats seront initiés par Clément Fortin, P-DG du CRIAQ (Consortium de recherche et d’innovation en aérospatiale au Québec), qui présentera notamment le modèle de recherche collaborative développé au CRIAQ et fera le point sur les développements en cours en avionique au Canada.

Bruno Monsuez, Directeur du Laboratoire Electronique et Informatique de l’ENSTA ParisTech, prendra ensuite la parole pour passer en revue les travaux en cours dans le domaine des systèmes HPC embarqués de classe safety-critical. De plus en plus complexes, ces systèmes se caractérisent aujourd’hui par une explosion de composants logiciels exécutés sur des plateformes matérielles distribuées. Les contraintes de prédictibilité nécessaires aux certifications restant les mêmes, cette complexification appelle de nouvelles méthodes. C’est l’objectif de cette intervention que d’en présenter l’état actuel et les perspectives.

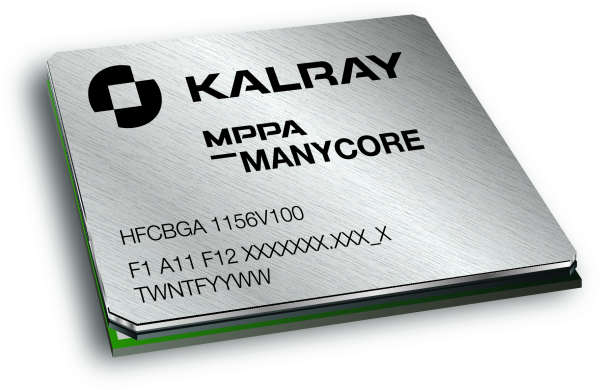

Directeur de Kalray Solutions, Laurent Julliard abordera ensuite les questions relatives à l’utilisation de processeurs manycore en environnements embarqués. Architecte fabless, Kalray, rappelons-le, produit le processeur MPPA 256, qui intègre 256 unités de calcul dans une enveloppe consommant environ 5W. On peut penser que les réflexions menées ici résonneront également aux oreilles des chercheurs qui réfléchissent à l’intégration massive de processeurs parallèles dans les architectures exascale.

Après une pause café bienvenue, Jacques Duysens et Philippe Ravier, respectivement Directeur Général et Directeur R&T de Silkan, présenteront à l’assistance la technique mathématique dite de model reduction, qui permet de modéliser en HPC des phénomènes physiques complexes. Cette approche semble promettre, peut-être à terme proche, d’importantes avancées dans la mise au point des systèmes embarqués temps réel présentant de haut niveaux de dépendance.

Enfin, Thierry Chevalier, Head of engineering methods & tools architecture chez Airbus, évoquera l’évolution nécessaire des méthodes de gestion de données dans la conception de systèmes mécatroniques. Ces systèmes évoluant eux-mêmes de produits discrets en systèmes composites, il est en effet indispensable, pour la bonne fin des projets, que les outils et pratiques d’ingénierie s’adaptent.

La simulation numérique des matériaux

(Amphi 2 – Mercredi 26 juin de 9h00 à 13h00)

Depuis quelques années, le HPC a radicalement transformé le domaine de la simulation des propriétés des matériaux. A cela deux explications. D’une part, une bien meilleure maîtrise de la complexité, les propriétés intéressantes résultant généralement de l’interaction d’effets à plusieurs échelles, de l’atomique au macroscopique. D’autre part, des possibilités de mise en œuvre d’interactions complexes, notamment à l’échelle atomique. Ces deux bénéfices expliquent que la simulation prédictive soit devenue un enjeu industriel de première importance, tant dans le domaine de la simulation du comportement des systèmes que dans la réalisation in silico de nouvelles molécules ou assemblages répondant à des besoins spécifiques.

Présidé par Gilles Zerah, du CEA, cet atelier propose un panorama de l’état de l’art dans trois domaines industriels particulièrement concernés par ce type de simulation : la mécanique avec Michelin, la chimie avec Unilever et les biotechnologies avec GSK. Pour chacun de ces trois champs d’applications et de recherches, des ingénieurs appartenant aux sociétés citées prendront la parole pendant 30 minutes environ pour décrire l’état actuel de leurs travaux et les perspectives qui sont les leurs à moyen et long termes. Il se murmure d’ailleurs que certaines interventions devraient être particulièrement inspirantes, et en tous cas porteuses d’idées nouvelles applicables à un large éventail d’autres secteurs.

Gilles Zerah devrait également présenter un certain nombre de simulations en conditions extrêmes réalisées sur le calculateur Tera100 du CEA, qui démontreront si besoin en était les bénéfices que l’industrie peut tirer du HPC dans les recherches les plus avancées. Enfin, l’atelier se conclura par une autre présentation, celle du CECAM (Centre Européen de calcul atomique et moléculaire), réseau organisé en nœuds régionaux et nationaux et destiné à la mise commun des nouvelles idées et pratiques dans ce domaine. Un must pour tous les spécialistes de la simulation.

Big Data et HPC

(Amphi 3 – Mercredi 26 juin de 9h00 à 13h00)

Sujet ô combien à la mode, comme en témoigne mois après mois nos colonnes, la perspective d’une convergence prochaine entre HPC et Big Data ne fait plus guère de doute. La raison en est simple : la recherche, comme l’ensemble des activités humaines faisant intensément appel à l’informatique, est de plus en plus souvent confrontée au déluge des données produites. Or, à partir d’une certaine volumétrie, les données ne peuvent plus être gérées avec les outils traditionnels. La communauté HPC est donc amenée à adopter des méthodes innovantes dont certaines, précisément, ont été défrichées par les spécialistes de ce que l’on appelle globalement le Big Data.

Pour résumer, le Graal, en ce domaine, c’est l’extraction rapide voire en temps réel des informations les plus pertinentes dans le contexte d’un problème donné. Présidé par Ange Caruso et George Hébrail, d’EDF, ainsi que par Guillaume Colin de Verdière, du CEA, cet atelier a pour objet d’en évaluer les enjeux, les problématiques et les méthodes les plus récentes, en rassemblant des spécialistes de renommée mondiale. Point intéressant, les discussions devraient se placer principalement du point de vue Big Data, en essayant de mettre en avant l’apport des techniques déjà établies dans le monde HPC.

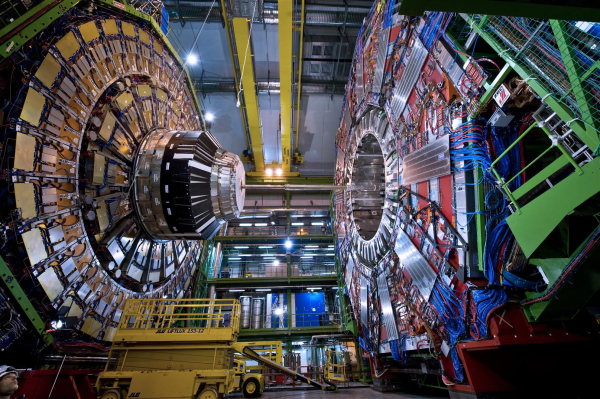

Parmi les intervenants, Bob Jones, responsable du projet OpenLab au CERN, abordera les approches et les technologies actuellement en cours d’évaluation qui devraient permettre de répondre aux besoins extrêmes du LHC en matière de gestion de données sur les 15 prochaines années. Julien Laugel, de MFG Labs, reviendra sur la question des défauts inhérents à Hadoop / MapReduce quant à la gestions des graphes, et fera le point sur les solutions permettant précisément de contourner MapReduce, avec un focus particulier sur le temps réel. D’autres experts HPC / Big Data d’EDF, Intel, SAP et Orange prendront quant à eux la parole pour relater leurs propres expériences dans des domaines tels que l’analyse rapide de données, la modélisation ou encore les bonnes pratiques en vigueur chez les grands acteurs du cloud computing.

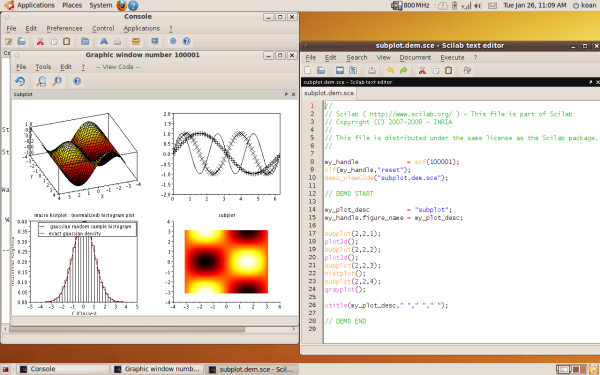

5ème journée des utilisateurs Scilab

(Amphi 4 – Mercredi 26 juin de 9h00 à 17h00)

Tout spécialement destiné à la communauté des utilisateurs de Scilab et Xcos, cet atelier est un passage obligé pour qui souhaite bénéficier de retours d’expériences de tout premier ordre. Que vous soyez rompu aux finesses de cet outil Open Source ou que vous commenciez seulement à le prendre en main, vous en repartirez beaucoup plus riche d’idées et de perspectives. Le public visé étant d’abord industriel, cette journée devrait connaître une audience encore en croissance par rapport à l’an dernier. Et comme de juste, priorité sera donnée aux sujets fonctionnels, avec des cas d’utilisation réels et des interventions axées sur le partage.

Une dizaine de speakers se relaieront pour couvrir aussi largement que possible les nombreux domaines d’utilisation de Scilab, en particulier dans les secteurs de l’énergie, de la défense et de l’aérospatial. Analyse et modélisation des données, boîtes à outil métier, utilisations en mesure online ou offline, aucun des grands champs d’utilisation ne manque à l’appel. Signalons qu’en fin de journée, François Bodin, de CAPS Entreprise, présentera en détail les meilleures stratégies pour tirer avantage des technologies de parallélisation présentes dans les accélérateurs AMD, Intel et NVIDIA. L’approche proposée a pour but de simplifier l’accélération des programmes Scilab par le biais des instructions de programmation parallèles OpenHMPP.

HPC et efficacité énergétique

(Amphi 1 – Mercredi 26 juin de 14h00 à 18h00)

Présidé par Marie-Christine Sawley, de l’Intel Exascale Lab de Versailles, cet atelier se consacre à l’un des sujets les plus épineux du HPC, non seulement pour le passage à l’échelle mais également pour la montée en puissance des plateformes actuelles de moindre envergure. L’objectif est de faire le point sur les recherches, nombreuses et diversifiées, qui visent à augmenter l’efficacité énergétique au niveau composants et au niveau systèmes. Y seront abordés notamment l’approche contrôle de consommation à partir de l’OS, l’impact de la pile applicative sur l’optimisation de cette consommation, et plus globalement les travaux en algorithmique menés dans ce sens. Les avancées les plus récentes, par exemple la caractérisation énergétique et les méthodes d’équilibrage de charge y seront détaillées. Ces présentations devraient faire écho à l’interview que nous avait accordé le Pr William Jalby de l’UVSQ, par ailleurs Chief Scientist de l’Intel Exascale Lab, dans notre numéro de mai.

Si le sujet recouvre vos préoccupations, nous vous invitons à ne pas manquer cette session. De prestigieux intervenants vont en effet se succéder au pupitre, à commencer par John Shalf, des Lawrence Berkeley Labs, qui parlera de nouvelles techniques plus pointues que le voltage dynamique et l’adaptation des fréquences d’horloge (DVFS). Le Dr Shalf fera le point sur les approches les plus agressives étudiées aujourd’hui pour les processeurs mobiles, et sur les défis qui restent à relever dans leur implémentation au sein de systèmes plus globaux, en particulier en matière d’hétérogénéité et de programmabilité.

Vincent Keller, de l’EPFL, prendra ensuite le relai pour présenter une nouvelle métrologie, la quantité Energy-to-Solution, son application sur plusieurs processeurs récents et les implications de l’ensemble sur les stratégies systèmes de gestion de l’électricité.

Rosa Badia, représentante bien connue du Barcelona Supercomputing Center, interviendra ensuite sur plusieurs outils d’importance dans la chasse au Joules, en particulier la bibliothèque d’équilibrage de charge DLB et un algorithme d’équilibrage précis, LeWI, qui se combinent particulièrement bien au modèle de programmation OmpSs. L’idée sous-jacente est de réduire la consommation par la réduction des temps de traitements en augmentant ce que le Dr Badia appelle la malléabilité système.

Après une courte pause, trois autres présentations proposeront diverses approches appliquées. Benoît Pradelle, de l’UVSQ, se propose de décrire deux projets dans lesquels des techniques affinées de DVFS (Dynamic voltage and frequency scaling – évoqués plus haut) produisent des résultats probants. Daniele Taffani, du Leibniz Supercomputing Centre, abordera les stratégies mises en œuvre par le projet Mont-Blanc aux niveaux matériel, logiciel et infrastructure. L’objectif officiel de Mont-Blanc est en effet de réduire de 15 à 30 fois la consommation énergétique du système éponyme. Enfin, Sébastien Cabaniols, de HP, reviendra sur les ruptures technologiques en matière de densité et de consommation proposées par la gamme de serveurs Moonshot, récemment lancée et dont on attend des déclinaisons spécifiquement HPC pour la fin de l’année 2013.

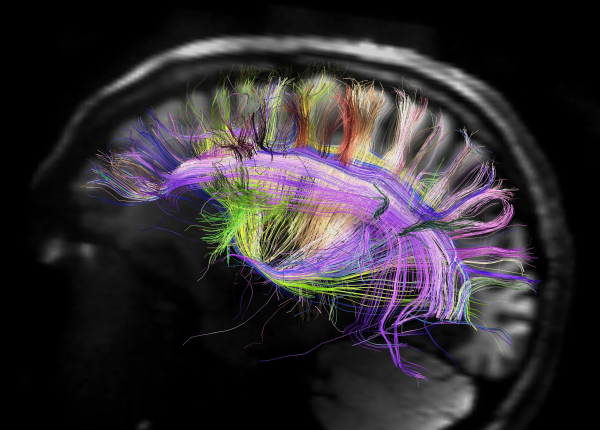

Le HPC dans la Santé

(Amphi 2 – Mercredi 26 juin de 14h00 à 18h00)

Ce n’est un secret pour personne, les secteurs de la biologie et de la santé recourent de plus en plus souvent au HPC pour faire avancer recherche fondamentale et travaux appliqués. Deux grands domaines sont concernés. D’une part, la simulation de phénomènes complexes : modélisation moléculaire, physiome, mécanismes des affections, effets des médicaments, conception de nano-systèmes, de biomatériaux, d’organes artificiels ou de robots chirurgicaux ou d’assistance au handicap. D’autre part, le traitement de grosses volumétries de données biologiques (génomique, protéomique…) et cliniques (imagerie médicale, épidémiologie…). Organisé conjointement par Teratec et Medicen, cet atelier a pour objectif de faire émerger les grands axes des initiatives futures associant Santé et HPC.

Après un exposé introductif du Dr. François Ballet, président du Comité R&D du pôle de compétitivité Medicen, sur les grandes orientations actuelles de l’usage du HPC en santé, le programme se propose de revenir plus en détails sur l’état de l’art en matière de biologie intégrative, en particulier pour la recherche et la conception de nouveaux médicaments, et sur l’usage de l’imagerie médicale et des techniques de réalité virtuelle. Des quatre exposés successifs se dégageront naturellement les prochains horizons de la recherche.

Ne manquez pas en particulier l’intervention de Denis Le Bihan, Directeur de NeuroSpin, le centre d’imagerie cérébrale en champ intense attaché au CEA. Le Dr Le Bihan, spécialiste mondial de l’imagerie par résonance magnétique, nous emmènera en voyage au cœur de nous-mêmes dans des contextes aussi divers que la perception musicale, les processus inconscients à l’origine de nos décisions ou encore le développement du cerveau in utero. En ligne de mire de ses travaux se trouve la recherche du “code neural”, lien supposé entre atome et pensée, c’est-à-dire entre la matière et l’esprit.

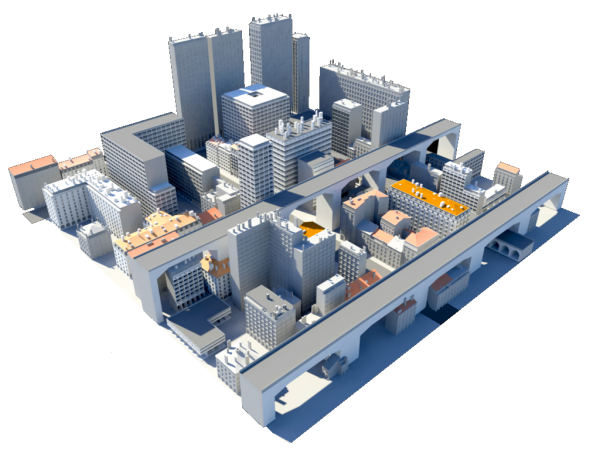

Modélisation et simulation au service de la ville durable

(Amphi 3 – Mercredi 26 juin de 14h00 à 18h00)

L’irruption et bientôt l’ubiquité du numérique dans nos villes accélère l’évolution de l’urbanisme. Nouvelles constructions, transformation des réseaux techniques, intermodalité des modes de mobilité, ces modifications se conjuguent pour faire de la ville un organisme vivant, “aspirant à l’éternité” comme le disent si joliment Vincent Cousin (Advancity) et Etienne de Pommery (ESI Group), qui présideront aux débats.

Comme l’article Des GPU pour des villes plus vertes le soulignait dans notre numéro de mars, ces spécificités induisent un niveau de complexité élevé pour la simulation, outil aujourd’hui indispensable aux architectes, urbanistes et techniciens qui participent à cette évolution. La composante dynamique, notamment, constitue une vraie différence par rapports aux objets traditionnels de la simulation.

Particularité supplémentaire, la ville est un bien commun. Elle appartient à sa population, qui compte sur une variété de fournisseurs de services et d’acteurs économiques pour en développer les usages. De sorte qu’un même territoire peut être la cible d’une infinité de simulations (phénomènes naturels, dispersion des pollutions, transports, activités économiques, densités d’habitats, réseaux de télécommunications…), chacune correspondant à la vision de ses utilisateurs. C’est la raison pour laquelle cet atelier, qui relie utilisations du HPC et enjeux sociétaux, fait intervenir des chercheurs et des industriels en prise directe avec les problèmes que cette évolution suscite.

Souheil Soubra, du CSTB, présentera plusieurs méthodes d’approche de cette ville numérique. Parmi elles, la création d’un référentiel unique pour l’ensemble des acteurs impliqués a pour but d’alimenter des codes de simulation de phénomènes physiques couplés et d’aboutir à ce que les projets d’aménagement soient évalués de façon systémique, en mode multicritères.

Plusieurs spécialistes se succéderont ensuite (Renault, Franck Boutté Consultants, INRA, Bouygues Bâtiment…) pour identifier différentes problématiques connexes : techniques de simulations urbaines, impacts environnementaux à grande échelle des choix d’aménagement, bonnes pratiques des grands bâtisseurs, avec notamment l’exemple de la construction du grand Sports’ Hub de Singapour.

L’atelier se conclura sur les interventions du Dr Fabien Brocheton, Directeur technique de Numtech, et de Philippe Bisch, Président du groupe Innovation de Syntec Ingénierie et Président honoraire de l’Association Française du génie parasismique. Respectivement spécialistes de la modélisation de la pollution de l’air et des risques sismiques, ils reviendront chacun sur ce que la simulation numérique adaptée à l’urbanisme peut apporter de décisif dans la prévention des risques majeurs, et détailleront les bénéfices que chacun d’entre nous peut en attendre dans ses activités professionnelles et son vécu quotidien.

© HPC Today 2024 - All rights reserved.

Thank you for reading HPC Today.