Lors de la première journée du Forum Teratec, les sessions plénières sont traditionnellement dédiées à la stratégie des entreprises et des États en matière de HPC. Ce mardi 25 juin, elles illustreront une fois encore la diversité des usages du calcul intensif et de la simulation, en revenant en détails sur les progrès accomplis et les innovations apparues depuis la dernière édition. Grands industriels, fournisseurs de technologies, utilisateurs très avancés, PME innovantes… autant de visions et de problématiques qui devraient donner lieu à de passionnants échanges.

• Technologies de rupture en ingénierie HPC (Ch. Farhat, Stanford)

• L’exascale et le Big Data au NERSC (S. Dosanjh, NERSC)

• Evolution et défis en ingénierie par simulation (S. Odorizzi, ENGINSOFT)

• Les défis du HPC (M.-P. de Bailliencourt, Bull)

• Le calcul haute performance, outil stratégique d’une entreprise (J.-F. Minster, Total)

• Les bénéfices de la simulation numérique pour Air Liquide (R.Réau, Air Liquide)

• Débogage et profilage HPC, aujourd’hui et demain (D. Lecomber, Allinea Software)

Technologies de rupture en ingénierie HPC

Charbel Farhat

Director, Army High Performance Computing Research Center, Stanford University

Dans cette session qu’on peut prédire brillante, le Pr Farhat se propose de faire le point sur les technologies récemment apparues (et disparues) dans la communauté HPC, pour évaluer les acquis actuellement les plus stables. L’idée sous-jacente, car ce panorama n’est évidemment pas une fin en soi, est d’identifier les meilleures pistes susceptibles de renforcer les usages de la simulation numérique. Aux dires du Pr Farhat, le problème est qu’aujourd’hui, la simulation est encore trop gourmande en ressources machine pour devenir l’approche standard dans la conception et l’ingénierie. Si l’on veut que se matérialise cette “routine” (selon ses propres termes) dans les opérations où l’aspect temps est essentiel, un certain nombre de ruptures avec l’existant sont donc indispensables. A côté des recherches visant l’exascale, des technologies émergentes ont vocation à relier les deux extrémités du spectre : supercalculateurs privés et HPC en tant que service cloud. Parmi ces nouvelles tendances, l’approche par model order reduction paraît très prometteuse. Elle fera l’objet d’un long focus qui sera le point d’orgue de cette intervention.

L’exascale et le Big Data au NERSC

Sudip Dosanjh

Directeur, NERSC, Lawrence Berkeley Laboratory

On sait que le Département de l’Energie américain (DOE) est un des principaux initiateurs technologiques dans le domaine du HPC outre-Atlantique. L’objectif du Dr Dosanjh, dans cette session, n’est rien moins que de décrire comment le National Energy Research Scientific Computing Center (NERSC) du DOE travaille activement à atteindre l’exaflops et l’exabytes en 2022. Le Centre compte aujourd’hui 4 500 utilisateurs issus de laboratoires universitaires, institutionnels et industriels, ce qui en fait une plateforme très polyvalente mais l’oblige à maintenir une infrastructure de grandes dimensions.

D’ici à la fin de la décennie, les responsables du NERSC souhaitent permettre aux chercheurs dans de nombreux domaines d’exécuter facilement des simulations de plusieurs centaines de Pétaflops. Pour cela, des systèmes pré-exascale seront déployés en 2016 (NERSC-8) et 2019 (NERSC-9), avec à chaque fois un équilibrage des capacités entre calcul et gestion des données. C’est la roadmap de cette montée en puissance que le Dr Dosanjh a prévu de présenter avec, incidemment, la création d’un complexe de 3 000 m² (le Computational Research and Theory Center), bénéficiant de 40 MW de puissance électrique et équipé des toutes dernières technologies de traitement de données, de stockage et de réseau à très haute vitesse. Une session qui devrait combler les spécialistes système.

Evolution et défis en ingénierie par simulation

Stefano Odorizzi

Président, ENGINSOFT, S.p.a.

Expert mondialement reconnu dans le domaine des sciences de la simulation, le Pr Odorizzi tracera dans son intervention les contours d’un nouveau paradigme en cours de généralisation. Il semble clair que la modélisation multi-échelles, à partir d’approches pluridisciplinaires, est aujourd’hui la seule voie possible pour la simulation de systèmes complexes à fortes interdépendances, surtout si l’on élève le niveau des standards de précision requis. Or, dans la plupart des contextes, on doit aussi viser l’optimisation multi-objectifs et la quantification des incertitudes, de sorte que les volumes de données obtenus explosent. D’où la nécessité dans laquelle se trouve la communauté des utilisateurs de dépasser les horizons de performance actuels, tant logiciels que matériels. L’objectif, pour le Pr Odorizzi, est de complètement libérer les ingénieurs des contraintes du calcul, c’est-à-dire de leur permettre de tester à l’envi des idées que les calculateurs modéliseront en temps réel. Cette session se propose d’identifier les obstacles qui nous en séparent.

Les défis du HPC

Marie-Pierre de Bailliencourt

Directrice générale adjointe, Bull

“Le HPC fait partie des technologies clés de l’évolution scientifique, technique et sociale de ces prochaines années. Il est au coeur des problématiques d’usages qui s’ouvrent aux chercheurs, aux entreprises et, à terme, aux particuliers.

Deux défis majeurs structurent son évolution : le premier concerne sa mise à la disposition de publics plus larges et plus diversifiés. Le HPC doit sortir des grands laboratoires de recherche et des grandes entreprises industrielles pour atteindre les PME, les ETI et offrir aux utilisateurs les outils de leur innovation et de leur compétitivité. Le cloud HPC y contribuera en grande partie, en offrant à la demande la performance requise. Le développement accéléré des applications d’usage (analyses prédictives, modélisation et simulation, gestion de contenus, contrôle des flux, services déportés, etc.) appellera également cette nécessaire démocratisation d’accès.

Le second défi est celui de la performance exaflopique et des nouveaux paradigmes qu’elle appelle en termes de fiabilité, d’efficacité énergétique et de parallélisme notamment. Les grands constructeurs se sont donnés cette ambition aux alentours de 2020. Bull en fait partie. Cette maîtrise de l’exaflops est un enjeu mondial stratégique car elle donnera corps à de nouvelles lois informatiques et à une nouvelle gouvernance de l’information et de l’intelligence humaine. Il est donc indispensable qu’elle s’inscrive dans une perspective démocratique, plurielle et ouverte.“

Le calcul haute performance, outil stratégique d’une entreprise

Jean-François Minster

Directeur scientifique, Total

Détenteur du plus gros calculateur privé au monde (Pangea – 2,3 Pflops, voir les actualités de notre numéro d’avril), Total dispose également d’autres machines très performantes, quoique de moindre puissance, installées dans diverses filiales en Europe et aux Etats-Unis. Pour le Groupe, le calcul intensif est utile dans une variété de domaines d’applications et pour différents objectifs. Les applications concernent l’exploration sismique pétrolière, la simulation des réservoirs d’hydrocarbures, les calculs de structures, la simulation des procédés et la compréhension des propriétés des matériaux et des interfaces. Les objectifs relèvent le plus souvent de la compréhension, mais de plus en plus de l’aide à la décision. A partir de l’exemple Total mais en élargissant à d’autres contextes industriels, cette session a pour vocation de démontrer combien le calcul à haute performance peut s’avérer rentable dans un contexte de production industrielle. A condition que l’on ne considère les calculateurs que comme les briques d’un dispositif plus large, comprenant équipes spécialisées par applications, codes dédiés (recherche, opérationnel) et partenariats techniques et technologiques.

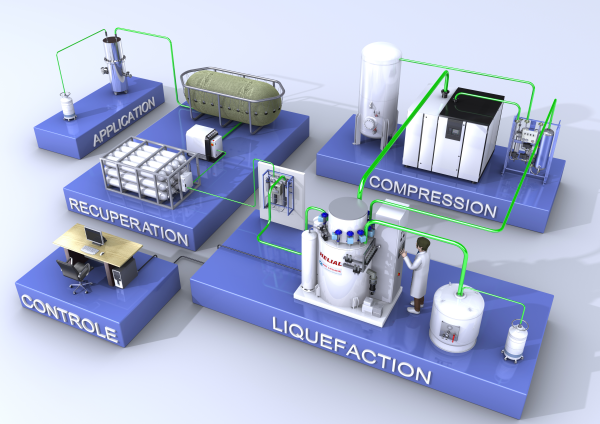

Les bénéfices de la simulation numérique pour les activités d’Air Liquide

Régis Réau

Directeur scientifique, Air Liquide

Dans cette autre session orientée retour d’expérience industrielle, Régis Réau soulignera l’importance de la simulation numérique dans la chaîne d’innovation qui permet de comprendre, de prédire et d’optimiser les processus d’Air Liquide et de ses clients. L’approche simulée ouvre en effet de nouvelles possibilités dans la production et l’utilisation de gaz à usage industriel, médical et environnemental, tout en accélérant leur mise sur le marché. S’appuyant sur des années d’utilisation, le Dr Réau mettra en évidence les multiples intérêts que les entreprises privées peuvent tirer des outils de simulation disponibles aujourd’hui à coût raisonnable (CFD, modélisation moléculaire), dans l’optimisation de la recherche opérationnelle, le contrôle de processus et la rentabilisation des investissements.

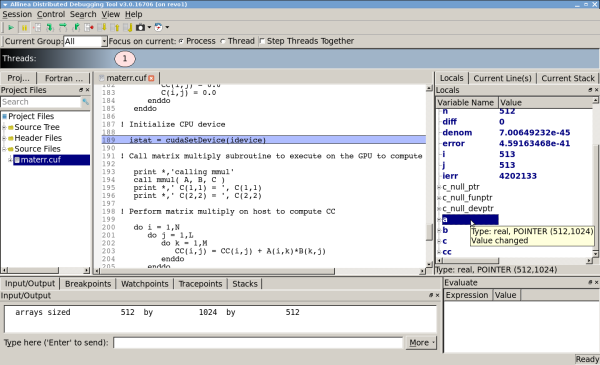

Débogage et profilage HPC, aujourd’hui et demain

David Lecomber

COO, Allinea Software

Point n’est besoin de présenter Allinea Software, spécialiste mondial des outils d’aide à la programmation parallèle à grande échelle. Dans cette session, David Lecomber passera en revue les défis auxquels doivent faire face les développeurs HPC sur la route qui mène à l’exascale. Les objectifs fondamentaux que sont l’exécution sans erreur et la recherche de performance maximale s’avèrent en effet de plus en plus difficiles à atteindre, d’autant que les technologies d’accélération GPU et x86, augmentant sensiblement les niveaux de concurrency, tendent à rendre les systèmes de plus en plus hétérogènes. Fournisseur de débogueurs et de profileurs capables de prendre en compte ce niveau de complexité, Allinea est en quelque sorte trend-setter dans ce domaine. Cette session sera donc illustrée par de nombreux exemples d’utilisation en situation réelle, et se terminera par la présentation des évolutions fonctionnelles de ces outils à court et moyen termes.

© HPC Today 2024 - All rights reserved.

Thank you for reading HPC Today.