Extrêmement gourmandes en calcul intensif, les recherches climatiques et météorologiques figurent parmi les premières bénéficiaires des nouvelles technologies HPC. Où qu’on se tourne, sur Terre ou dans les nuées, les progrès réalisés dans la modélisation et la finesse des prévisions sont spectaculaires. Tour d’horizon… à 360°.

On le sait, le climat et la météo sont intimement liés. Si les études météo couvrent des phénomènes qui se déroulent sur une échelle de temps courte, grosso modo de la minute à la quinzaine de jours, l’unité temporelle de la climatologie, pour sa part, varie de l’année à la décennie, quand elle ne s’étend pas au millénaire, dans le cadre notamment des débats sur le réchauffement de la planète. Cette complémentarité explique leur importance pour le bien-être du grand public, mais aussi pour la gouvernance de nombreuses activités économiques : industrie, assurance, énergie, transports…

Celle des deux disciplines qui nous touche le plus au quotidien, la météo, s’est révélée ces dernières années significativement plus précise – dès lors que les prévisions ne dépassent pas quelques jours. Or, ce seuil de fiabilité ne dépend pas uniquement de la quantité et de la qualité des données d’observation. Il est aussi fonction des performances des modèles informatiques et des outils matériels qui leur donnent vie.

Modéliser l’intersection climat / météo

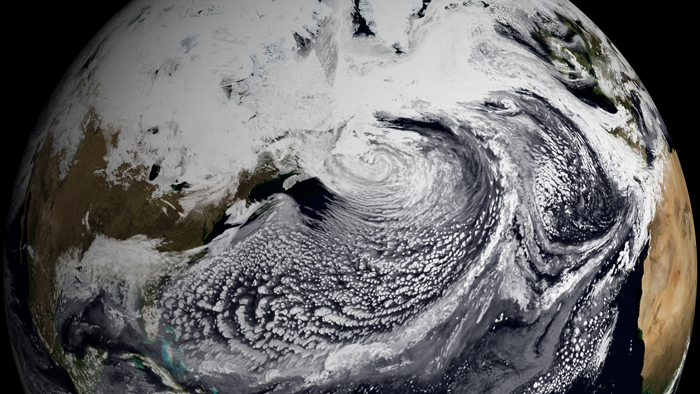

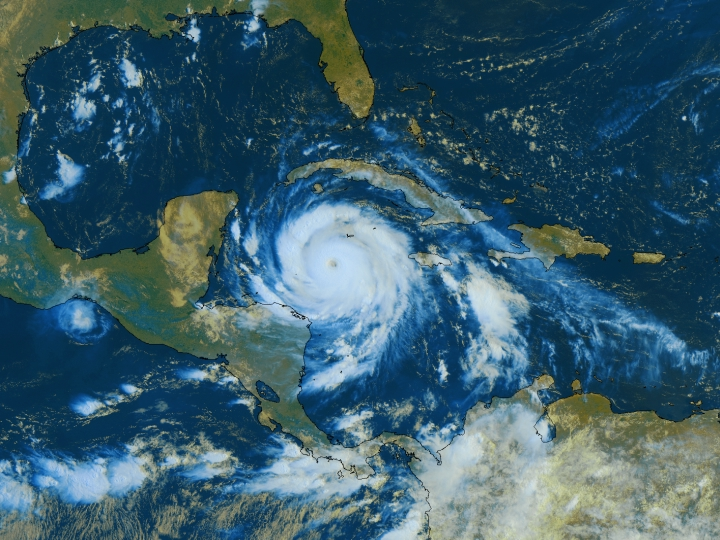

Ce constat est parfaitement illustré par les difficultés que rencontrent les scientifiques spécialisés en météorologie et climatologie globales. On ne comprend pas encore totalement, par exemple, la façon dont la convection tropicale interagit avec la dynamique atmosphérique de l’ensemble de la planète. Depuis 1971, on sait qu’un phénomène majeur influe sur cette intersection climat / météo : l’Oscillation Madden-Julian (MJO). Découverte par Tol Madden et Paul Julian du NCAR américain (National Center for Atmospheric Research), cette tendance décrit les déplacements vers l’Est, le long de l’équateur, de la convection et des précipitations. Aujourd’hui, quelque 40 ans après, des équipes du monde entier travaillent encore à sa modélisation. Car lorsqu’elle est active, la MJO intervient non seulement pour environ 30 % des pluies subtropicales, mais elle impacte également le climat et les températures de régions situées bien au-delà.

MJO, El Niño, l’intégration de ces événements dans les systèmes océano-atmosphériques sur une large échelle de temps et d’espace est bel et bien la nouvelle frontière de la recherche dans le domaine. George Kiladis, météorologiste chercheur au NOAA américain (National Oceanic and Atmospheric Administration), estime qu’une fois au point le modèle MJO, les prévisions météo à 15 jours seront aussi précises que celles qui nous annoncent le temps du prochain week-end.

Un modèle systémique pour les ressources en eau

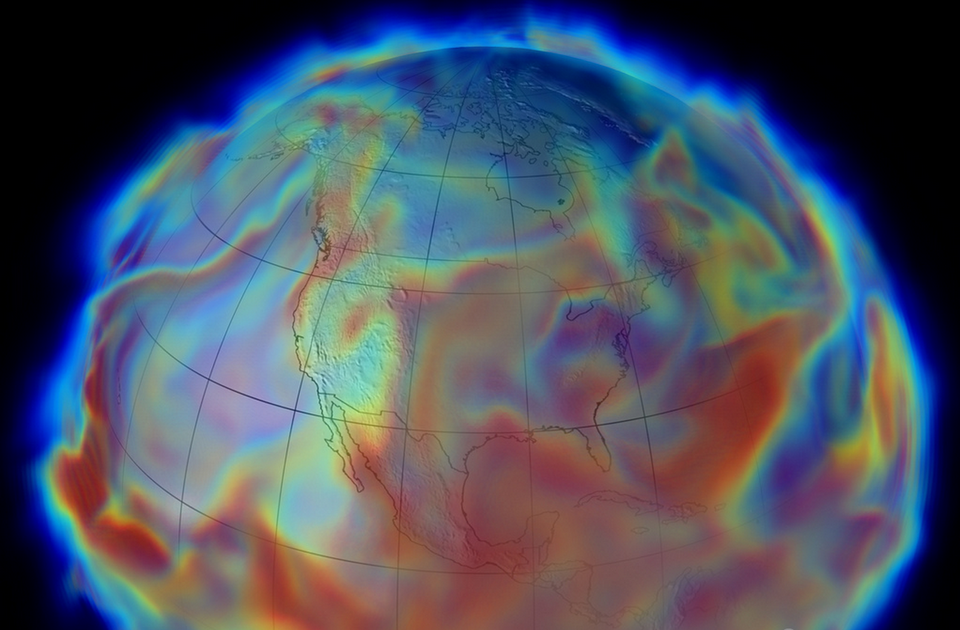

Le changement climatique – le fameux, celui fait tant polémique – est lui aussi l’objet de beaucoup de modélisations. Depuis longtemps, les spécialistes ont compris que, s’il s’avère à un degré important, son impact sur le cycle hydrologique global sera considérable. Ses effets seront perçus jusqu’à des niveaux très locaux, avec des risques de sécheresses ou d’inondations là où de mémoire d’homme on n’en a pas connues. Par ailleurs, les conséquences en matière de qualité, de quantité et de durabilité des ressources en eau se ressentiront dans un large spectre de domaines sociaux et économiques – santé humaine et animale, écosystèmes marins, production agricole, énergie … – avec tous les enjeux géopolitiques que cela signifie.

C’est ce qui a poussé le NCAR à développer Water System, un modèle systémique destiné à décrire avec une précision opératoire ce fameux cycle hydrologique global. A l’agrégation de modèles régionaux ou spécialisés s’ajoute dans ce programme des études sur les effets à grande échelle de la fonte des glaces ou encore d’activités humaines telles que la création de barrages, l’aménagement des surfaces, etc.

Sécheresses annoncées dans le Sud de l’Europe

L’affaire n’est pas mince. Sur un certain nombre de phénomènes comme les sécheresses, les données rétrospectives issues des modèles spécialisés ne correspondent pas à l’observation historique. L’explication pourrait venir de la difficulté qu’on a à répliquer les interactions air-océans, ce qui ensuite affecte les projections de précipitations. Les climatologues ont été nombreux à en conclure que les prédictions actuelles de sécheresses étaient probablement surévaluées, tant en nombre qu’en sévérité.

Pour affiner le modèle et mieux répliquer les températures en surface des océans, des chercheurs de Water Systemont développé une méthode statistique qui spécifie leurs variations naturelles. Avec la prise en compte de ce nouveau paramètre, ils se sont rendu compte que les modèles gagnaient beaucoup en précision. Les événements du passé commencent maintenant à être fidèlement “prédits”. C’est la bonne nouvelle. La mauvaise, en revanche, c’est que les projections de sécheresses restent inquiétantes. Aucune région du monde ne devrait être épargnée, jusqu’au Sud de l’Europe qui pourrait connaître, dans les 30 ans, des catastrophes de grande ampleur.

La tête dans les étoiles

A la NASA aussi, la simulation climatique bénéficie de ressources importantes. Le NCCS (Nasa Center for Climate Simulation, intégré au Goddard Space Flight Center) est notamment en charge de mettre à disposition de chercheurs du monde entier un large éventail d’observations satellites. Ces datasets alimentent également des modèles qui, en fonction de l’organisme client, s’étendent de quelques jours (pour les prévisions météo) à quelques siècles (pour les projections de changement climatique).

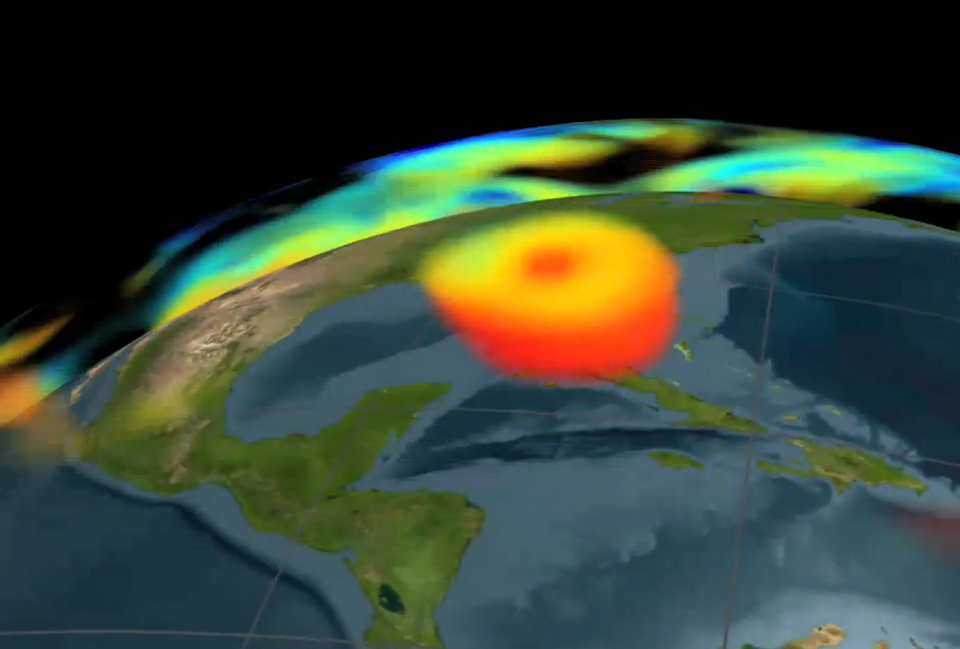

Le NCSS dispose par ailleurs de son propre département de modélisation climatique – le GMAO (Global Modeling and Assimilation Office). Celui-ci traite pas moins de 8 millions d’observations par jour, ce qui constitue la base de données la plus exhaustive pour la simulation de processus physiques autour du globe. Sachant que les données simulées sont de même type que les données observées – températures, humidité, vitesse et direction du vent, précipitations, etc. – les contraintes techniques relatives à leur traitement sont loin d’être négligeables. Ainsi, le projet le plus sophistiqué que le GMAO ait conduit à ce jour – Modern Era Retrospective-analysis for Research and Application (MERRA) – a généré à lui seul pas moins de 150 To d’informations nouvelles.

Tesla et Xeon Phi cohabitent

Pour exécuter ces programmes, le NCSS dispose évidemment de son propre calculateur, Discover, n° 53 au Top500 (et 31 au Green500). Avec une puissance de crête de 1 Pflops, celui-ci a depuis peu intégré 480 accélérateurs Xeon Phi au sein d’un de ses sous-systèmes cluster. Toutefois, ce sont des GPU NVIDIA Tesla qui sont utilisés pour maximiser les performances de GEOS-5, le modèle de circulation atmosphérique générale du Centre.

Pour Bill Putman, ingénieur météorologiste responsable du développement de GEOS-5, “l’avantage de l’accélération GPU est double. D’une part, elle augmente sensiblement l’efficacité et la performance de nos modèles. D’autre part, elle permet à un nombre beaucoup plus élevé de chercheurs du monde entier d’accéder à ces modèles à partir d’un PC de bureau accéléré, à des résolutions pouvant descendre jusqu’à 100 km“.

De l’estimation à la réalité

Exemple type des progrès réalisés grâce aux nouvelles technologies HPC : le traitement des systèmes nuageux. Les nuages présentent des propriétés de radiation qui impactent significativement l’exactitude de GEOS-5. Le problème, c’est qu’ils ne se forment qu’à très petite échelle. Avant les GPU, les processus de formations nuageuses ne pouvaient être qu’estimés dans le modèle. Avec les GPU, ils peuvent être traités en réalité, à une résolution d’environ 3,5 km, d’où une bien meilleure exactitude des données produites.

Sachant que GEOS-5 est écrit principalement en Fortran, Bill Putman et ses collègues utilisent des compilateurs PGI pour accéder directement aux ressources des GPU sans pour autant rendre ces derniers nécessaires. Ainsi, l’adaptation à l’accélération se fait de façon transparente pour l’utilisateur final du modèle : les scripts de make permettent la compilation de versions CPU ou GPU dont l’exécution donne des résultats parfaitement identiques.

Météo France en cours de parallélisation

Dans notre beau pays, les équipes de Météo France doivent elles aussi faire face à d’importants défis en matière de dimensionnement du traitement et du stockage de données. Aujourd’hui, la prévision numérique que MF livre à ses clients repose sur 3 modèles. Arôme, modèle à maille fine (2,5 km), est utilisé pour les prévisions à très courte échéance, de l’ordre d’une trentaine d’heures. Arpège, lui, maille l’Europe moins finement (10 km) mais permet des prévisions jusqu’à 4 jours. Enfin, c’est le modèle ECMWF (European Centre for Medium-range Weather Forecasts) qui est utilisé pour les prévisions à 10 jours, avec une résolution de 16 km.

Les missions de Météo France ne s’arrêtent évidemment pas aux prévisions. Elles incluent, entre autre, la recherche sur la variabilité du climat et la chimie atmosphérique, autant de disciplines grosses consommatrices de données. C’est pour répondre à ces défis que les responsables techniques de MF viennent de choisir les supercalculateurs Bull B700 DLC, qui prendront très bientôt la relève de l’infrastructure actuelle.

Le refroidissement liquide à l’honneur

A l’heure où nous publions, un premier système sera en cours d’installation sur le site de Météo France à Toulouse. A l’automne, un second système sera livré à l’espace Clément Ader, toujours dans la ville rose. Selon le cahier des charges de “Calcul 2013”, le programme qui vise à couvrir les besoins de l’organisme jusqu’en 2018, la montée en charge se fera en deux temps. La première (double) installation atteindra 1 Pflops, puis montera à 5 Pflops à horizon 2016.

Mais la grande nouveauté du système retenu par MF, c’est le refroidissement liquide. Si l’on n’atteint pas encore un PUE (Power Usage Effectiveness) de 1, chiffre théorique indiquant que la totalité de l’énergie consommée l’est par les seuls serveurs, la technologie DLC de Bull améliore la performance énergétique d’environ 40 % par rapport aux solutions traditionnelles à ventilation. Le secret : une plaque froide en contact direct avec les composants chauffants et dans laquelle circule le plus pratique des fluides caloporteurs : l’eau tiède. Rendez-vous très bientôt pour une revue

de détails !

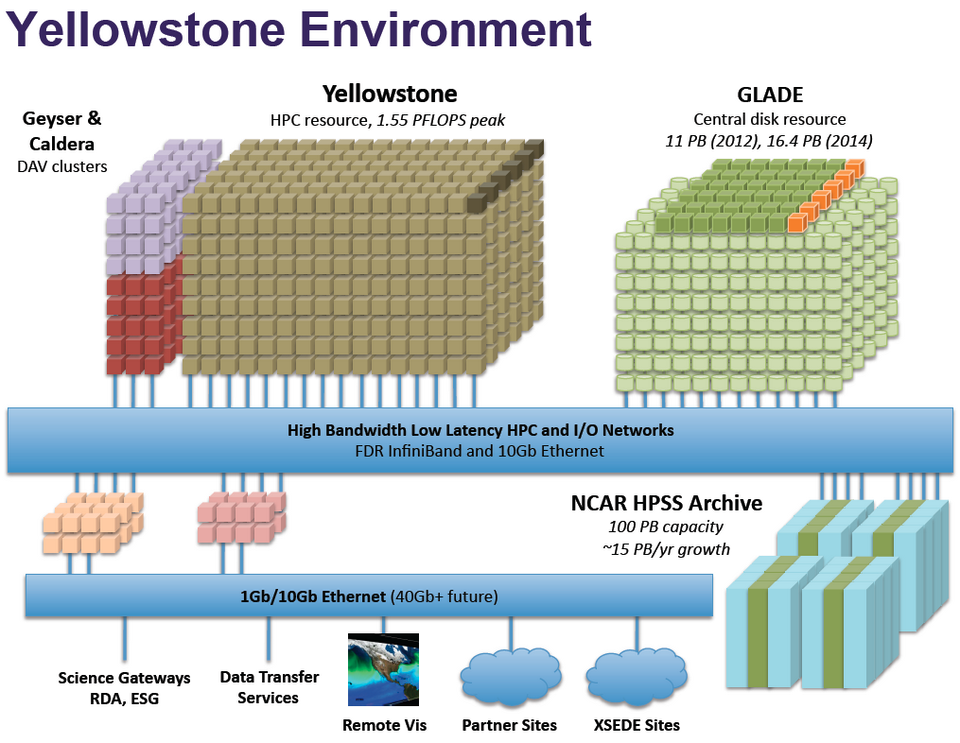

Yellowstone, le supercalculateur du NCAR

Mis en production à l’été 2012, Yellowstone sera exclusivement dédié aux recherches interdisciplinaires en sciences de la Terre. C’est à lui que reviendra d’analyser les données de l’ensemble des modèles qui constituent le programme Water System. Situé à Cheyenne, dans l’état du Wyoming, Yellowstone est un cluster IBM iDataPlex de 1,5 pétaflops. Il se compose de 4 518 nœuds disposant de 2 Xeon E5-2670 octo-cœurs reliés par un réseau de commutateurs Mellanox FDR InfiniBand, et 144,6 To de mémoire vive globale. C’est le Red Hat Linux for Scientific Computing qui a été choisi pour l’opérer, sur la base du système de fichiers IBM GPFS (General Parallel File System).

Sa particularité est d’offrir un espace de stockage partagé qui accélère la logistique informatique des travaux de recherche. Baptisée GLADE (GLobally Accessible Data Environment), cette plateforme propose des espaces de travail de calcul, d’analyse et de visualisation communs à toutes les disciplines. Pas moins de 11 Po d’espace disque sont ainsi partagés par le calculateur lui-même, deux clusters d’analyse et de visualisation de données (“Geyser” et “Caldera”), plusieurs serveurs de données exposés à des utilisateurs locaux et distants, et un cluster d’archivage de données de recherche dimensionné à plus de 100 Po.

Cette intégration des ressources de calcul, des systèmes de fichiers, du stockage et des réseaux à haut débit présente un gros avantage. Elle permet à la fois la simulation, l’analyse et la visualisation déportée en haute résolution à partir d’un seul système. Les scientifiques n’ayant plus à transférer d’importantes quantités de données entre plusieurs machines, la productivité de leur travaux s’en trouve nettement augmentée. En 2013, l’environnement Yellowstone devrait ainsi offrir plus de 600 millions d’heures/processeur à ses utilisateurs.

Concurrencez Météo France !

Vous avez un PC doté d’un accélérateur GPU ? Il vous suffit de télécharger le modèle WRF, du NCAR, pour disposer, chez vous, du même système de prévisions météo que celui utilisé par la Météo nationale et l’Armée de l’air américaines, ainsi que de nombreuses autres agences nationales de par le monde.

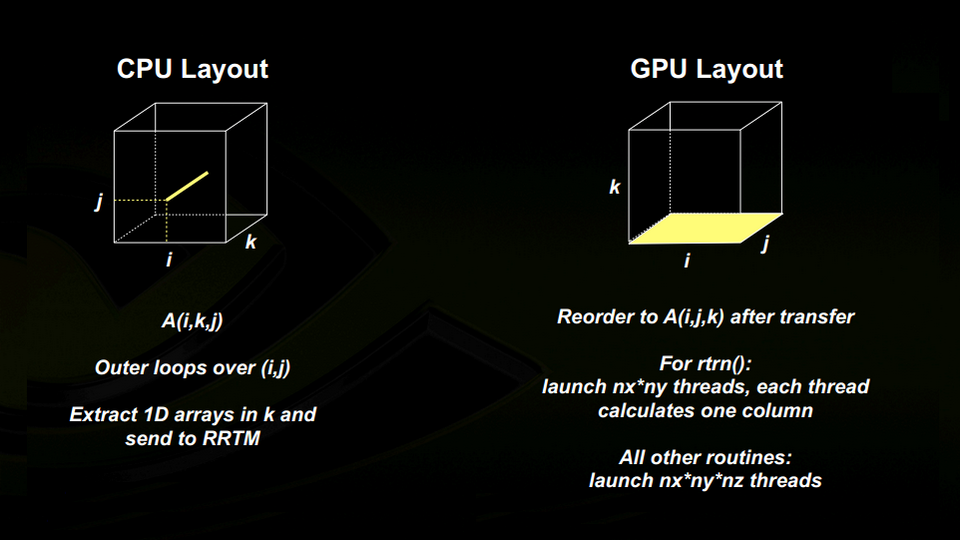

Bien sûr, ces organisations font tourner le Weather Research & Forecasting model sur des machines nettement plus sophistiquées qu’un simple ordinateur de bureau. L’ensemble des applications qui composent WRF sont ainsi récemment passées du tera au pétascale, ce qui n’a pas manqué de confronter les responsables du programme à un vrai problème de montée en charge. Le point avait été atteint au-delà duquel l’ajout de modules CPU n’était plus suffisant pour accélérer l’obtention des résultats, surtout sur les composants logiciels temps réel.

Les ingénieurs du NCAR ont alors décidé de porter le code de WRF vers CUDA, l’environnement de développement parallèle de NVIDIA. Leurs efforts se sont concentrés sur le kernel Microphysics, une des briques de base du modèle. Microphysics ne constitue qu’environ 1 % de WRF, mais il est déterminant pour les performances globales car très exigeant en puissance de calcul. Le bénéfice a été immédiat : 20 % d’accélération à l’exécution.

Comme le souligne John Michalakes, responsable du développement logiciel de WRF, “Ce résultat est très encourageant. Nous étions arrivés à la limite des possibilités des clusters conventionnels pour les prévisions temps réel et court terme. Aujourd’hui, notre objectif est de diviser les temps de calcul par 2, au moins, en utilisant l’accélération GPU dans un nombre croissant de composantes de WRF.“

D’autres voies d’amélioration ont envisagées, comme la conversion du Fortran en C puis l’affinage des algorithmes, une granularité plus fine du parallélisme et l’utilisation des fonctions matérielle spécifiques à l’architecture Tesla. La prochaine version téléchargeable de WRF disposera ainsi d’un switch “GPU”, qui permettra aux utilisateurs d’activer, très simplement, l’ensemble de ces optimisations.

More around this topic...

© HPC Today 2024 - All rights reserved.

Thank you for reading HPC Today.