Est-il encore besoin de démontrer la pertinence de l’approche accélérée dans le calcul à très hautes performances ? A peine mis en service, Titan s’inscrit déjà dans l’histoire comme la première étape effective sur la route de l’Exascale.

Depuis novembre 2012, c’est désormais le laboratoire américain d’Oak Ridge au Tennessee qui abrite le supercalculateur le plus puissant de la planète. Sa particularité ? Il est animé par 18 688 unités de calcul GPU, ce qui en fait l’étendard du High Performance Computing nouvelle génération.

A la pointe des efforts de recherche outre-Atlantique, Oak Ridge a fait partie du projet Manhattan visant à développer la bombe H au cours de la seconde guerre mondiale. Il figure ainsi parmi les laboratoires d’origine militaire qui jouent aujourd’hui un rôle de premier plan dans la recherche civile fondamentale et appliquée. Son historique et son rayonnement expliquent pourquoi ce complexe a souvent été l’hôte des supercalculateurs les plus puissants du moment.

Ce n’est donc pas une surprise si les américains reprennent la tête du Top500 – et cela grâce à la puissance de Titan, soit 20 Pétaflops soutenus et 27 Pflops en crête. Que ceux de nos lecteurs qui imaginent mal ce niveau de performances se représentent une heure de calcul à pleine puissance sur cette machine : elle correspond à 20 ans de calcul d’un PC actuel. Buddy Bland, directeur du projet Titan, a même qualifié son bébé de « machine à voyager dans le temps » tellement cette puissance augmente la portée des simulations visant à prédire le comportement des modèles mathématiques qui lui sont confiés.

La performance n’est toutefois pas le seul caractère distinctif de Titan, qui se singularise aussi par une remarquable efficacité énergétique. Sa consommation globale de 9 Mégawatts correspond à celle d’une agglomération américaine de 9 000 foyers. Certes, ce n’est pas négligeable, mais ce chiffre contredit la règle bien établie de la proportionnalité puissance / énergie requise, avec notamment un rendement 5 fois supérieur à celui de son prédécesseur, Jaguar. L’écart est tel, estime Buddy Bland, que « si nous avions voulu obtenir de telles performances avec une architecture conventionnelle uniquement composée de processeurs, la consommation aurait été de 30 MW, et nous aurait coûté 30 millions de dollars par an. » A 2 Gflops par Watt, Titan n’est donc pas seulement plus performant, il est aussi plus économe.

Architecture hautement parallèle

La grande innovation technique de Titan est donc le recours à l’accélération GPU à (très) haute densité. Au cœur de la machine, les 18 688 modules NVIDIA Tesla K20x – les mêmes (ou presque) qu’on peut installer dans un PC standard – contribuent pour environ 90% à la puissance de calcul globale servie aux utilisateurs.

Pourquoi le choix d’une architecture hétérogène (CPU + GPU) ? Dans un processeur conventionnel, un nombre de cœurs réduit exécute les instructions séquentiellement. Avec ce modèle traditionnel, l’augmentation de la performance passe donc par la multiplication des CPU, donc de la consommation d’énergie. Dans un tel contexte, on constate également que l’augmentation de puissance n’est pas linéaire, une partie de celle-ci étant consommée par les communications inter-processeurs. La première génération de Xeon, par exemple, ne fournissait dans une architecture quadri-processeurs que la puissance de trois CPU. Avec leurs multiples cœurs, les GPU ne présentent pas ce problème une fois les calculs logiquement parallélisés par le code source et répartis par le CPU.

Superlatifs

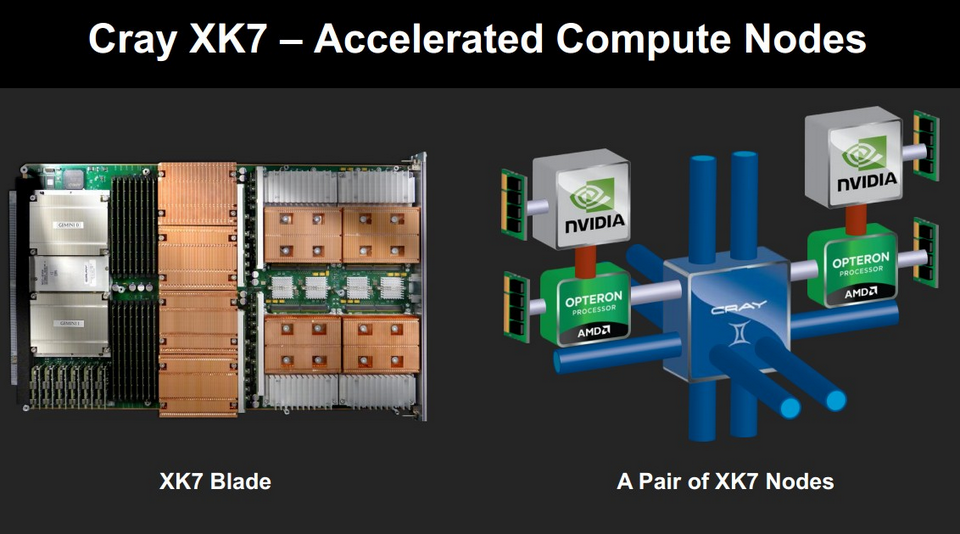

Occupant une surface au sol de 404m², Titan est constitué de 200 calculateurs Cray XK7 reliés via 512 armoires Cray Gemini 3D Torus Interconnect. Embarquant 6 Go de GDDR5, chacun des accélérateurs graphiques NVIDIA est associé à un processeur AMD Opteron 6274 à 16 cœurs flanqué de 32 Go de mémoire. Les couples sont organisés par paires pour former des lames rackables. L’ensemble, au final, représente la somme faramineuse de 710 Téraoctets de mémoire vive.

Gravé en technologie 32 nanomètre et cadencé à 2,2 Ghz (2,5 Ghz en mode turbo), le processeur AMD Opteron 6274 a pour particularité une extrême densité. Conçu pour les applications de calcul intensif, il intègre l’architecture DirectConnect 2.0, au sein de laquelle la technologie HyperTransport 3.0 assure des échanges à très haute vitesse (3,2 Go/s) entre les cœurs, le cache et la mémoire conventionnelle. Avec son contrôleur quadricanal incorporé, il atteint des débit bus de 6,4 GT/s maximum. L’Opteron 6274 dispose en outre de 768 Ko de mémoire cache L1 (en 8×64 Ko pour les instructions et 16×16 Ko pour les données), de 16 Mo (2×8 Mo exclusifs) de mémoire cache L2 à la même fréquence que le processeur, et d’autant de cache L3 (2×8 Mo partagés).

Les accélérateurs Tesla Kepler K20x, quant à eux, embarquent comme on l’a vu plus haut 2 688 processeurs de flux CUDA cadencés à 706 Mhz. Ils affichent sur le papier une puissance de calcul de 1,31 Téraflops en DP (3,93 Tflops en SP), parfaitement dimensionnable selon les besoins des équipes de chercheurs auxquelles Titan sera confié.

Repousser les limites de l’exploration humaine

De type Open Science, le centre de calcul d’Oak Ridge est à la disposition des chercheurs académiques et des laboratoires de recherche gouvernementaux mais aussi d’entreprises privées pour la modélisation mathématique de phénomènes physiques ou biologiques. Les performances de Titan sont d’ores et déjà appelées à servir plusieurs programmes de haut niveau qui devraient affecter durablement notre environnement de façon positive.

Parmi ces programmes, on compte bien sûr les nanotechnologies et l’étude des mécanismes qui régissent le comportement et les fluctuations des matériaux qu’elles utilisent. Comme le souligne le Dr Markus Eisenbach, du Scientific Computing Group d’Oak Ridge, « Titan autorise des calculs aussi fins et complexes que le niveau de température nécessaire pour qu’un matériau perde ses aptitudes magnétiques. Ce qui, ensuite, débouche sur de nouveaux matériaux requérant des coûts et des infrastructures plus efficaces d’un point de vue énergétique. »

La climatologie, qui couvre bien plus que la météo, devrait également être une des grandes bénéficiaires de l’arrivée de Titan. On sait que certains phénomènes sont extrêmement difficiles à simuler, donc à prévoir. C’est le cas notamment des corrélations entre la répartition des précipitations et l’ampleur des orages tropicaux. Selon Warren Washington, Senior Scientist au Centre national de recherches atmosphériques américain (NCAR), « une heure de calcul de Titan permet de simuler le climat de notre planète sur une période comprise entre 1 et 5 ans selon le niveau de précision souhaité, en mettant en relation les données globales complexes issues des modèles atmosphériques, océaniques, terrestres et glaciaires. »

Autre domaine de recherche ayant déjà préempté Titan, les simulations de combustion en trois dimensions ont un double objectif : améliorer le rendement énergétique des carburants fossiles et bio pour que l’industrie continue à optimiser le rendement des moteurs thermisques. Les travaux actuels ont pour objectif de réduire significativement – entre 25 et 50% – notre consommation de carburant. Le Dr Jackie Chen, du Laboratoire national de Sandia aux Etats-Unis, précise à ce sujet que « Titan va permettre de mieux examiner les turbulences induites par la combustion des carburants dont la composition complexe ne pouvait être analysée avec les moyens existants. »

Enfin, le niveau de précision qu’offre un supercalculateur comme Titan est précieux dans notre compréhension des phénomènes liés à l’exploitation des technologies nucléaires. Tom Evans, ingénieur à Oak Ridge, estime que Titan « va permettre la simulation d’un cœur de centrale en quelques heures au lieu de plusieurs semaine précédemment. » Et d’ajouter, « Pour nous, c’est un bond en avant fantastique. » L’objectif est bien entendu d’améliorer la sécurité et le rendement des centrales américaines – qui fournissent 20% de la consommation énergétique du pays – mais aussi de réduire durablement la proportion de déchets radioactifs, problème pratique n°1 de l’industrie nucléaire aujourd’hui.

Clairement, Titan inaugure une nouvelle génération de supercalculateurs. Quelles en seront les grandes orientations technologiques ? Quelle sera le niveau de performance du prochain n°1 au Top500 ? L’association CPU denses + GPU va-t-elle confirmer sa prédominance sur les autres architectures, à moins que l’impulsion d’Intel engendre d’autres grandes réalisations en architecture pleinement x86 ? Il est trop tôt pour le dire. Ce que l’on sait, en revanche, c’est que la prochaine génération, celle qui nous rapprochera un peu plus encore de l’exascale, devra résoudre des problèmes combinant plusieurs des défis que Titan et ses pairs sont d’abord appelés à relever. Simulation d’un modèle intégral du globe terrestre avec une précision de l’ordre du kilomètre, simulation de cellules vivantes aux niveaux moléculaire, génétique, chimique et biologique, validation des théories astrophysiques… Rendez-vous en 2020 !

Stampede – HPC «Texas-size»

Si Titan ouvre la voie du HPC hétérogène CPU + GPU à très très grande échelle, des solutions alternatives continuent d’être développées, notamment à base de Xeon Phi. Le supercalculateur Stampede du TACC (Texas Advanced Computer Center) en est l’exemple type. Mis en service le 7 janvier dernier, il constitue aussi la réponse d’Intel à NVIDIA. Ses 6 400 serveurs cluster Dell PowerEdge C822, répartis en 160 armoires, embarquent en effet chacun un accélérateur Phi. On compte bien 128 cartes NVIDIA Kepler, mais elles ne sont utilisées que pour la visualisation à distance avec calculs déportés. Précisons, pour la petite histoire, que la mémoire globale du système atteint 272 To et qu’elle est associée à un espace de stockage dédié de 14 Po géré en mode LUSTRE. Stampede étant lui aussi labellisé Open Science, il verra la gestion des tâches qui lui sont confiées orchestrée par Oracle Grid Engine.

More around this topic...

© HPC Today 2024 - All rights reserved.

Thank you for reading HPC Today.