Le HPC est un outil critique pour les activités de Shell. Disposer de capacités de calcul intensif bien dimensionnées permet de trouver des hydrocarbures dans des environnements géologiques de plus en plus complexes et difficiles d’accès, de les extraire plus efficacement et de répondre à la demande énergétique du monde en réduisant l’impact écologique de l’extraction.

Les besoins de Shell en matière de calcul augmentent régulièrement – et considérablement. Pour l’exploration en amont, les algorithmes propriétaires d’acquisition sismique génèrent des datasets de plus en plus volumineux. A cela s’ajoute des modèles de réservoir de plus en plus complexes, découlant de techniques de simulation avancées. Enfin, les programmes du département R&D et de nouvelle applications d’analyse intensive de données requièrent pour leur part également des capacités HPC de toute dernière génération.

Dans ce contexte, Shell a évidemment pour objectif de fournir à ses équipes la capacité HPC requise au TCO le plus contenu possible. La compagnie s’appuie pour cela sur ses deux datacentres de Houston et Amsterdam, le mot d’ordre étant de concentrer les ressources de calcul sur un nombre restreint de sites. Cette approche autorise un certain nombre d’économies d’échelle, permet de maintenir un haut niveau de service et devrait s’avérer pertinente lors de la transition vers les solutions cloud, qui s’amorcera dès que les propositions techniques auront atteint un degré de maturité suffisant.

L’importance qu’a pris le HPC pour Shell l’a conduit à établir un Centre d’Excellence (CoE) dès 2009. Sa mission : multiplier par cent le rapport performance/coût. L’adoption régulière des dernières technologies et un effort constant sur les codes logiciels s’inscrivent dans cet objectif, auquel contribue également plusieurs partenariats étroits avec des fournisseurs de technologies critiques. A terme, ces efforts ont vocation à offrir à Shell un avantage concurrentiel et technique déterminant pour le devenir de l’entreprise.

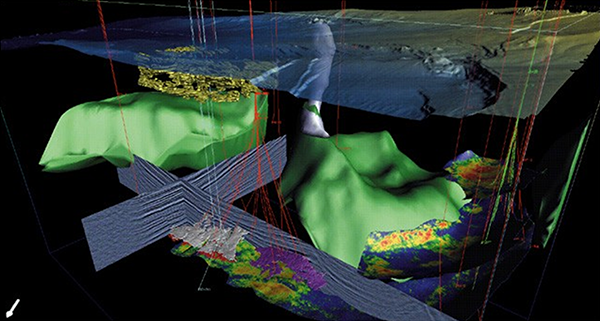

Modélisation et visualisation détaillées d’un dataset de “subsurface” complet. Les couleurs brillantes représentent les réservoirs de pétrole et de gaz situés sous les couches de sels. Cette visualisation représente l’état le plus abouti de l’analyse des données physiques par calcul intensif.

Une vision globale du HPC

La philosophie de Shell consiste à penser que le HPC ne concerne pas seulement le calcul. Pour être vecteur d’une valeur ajoutée d’usage maximale, il doit inclure les applications, les données, le stockage et son intelligence, les réseaux et les technologies de visualisation. L’approche du Centre d’Excellence HPC est donc la plus globale, la plus transverse possible. Pour cela, des contrats de coopération internes ont été institués. Avec le département Innovation, Recherche et Développement (IRD), qui fournit les technologies les plus élaborées dans le domaine géophysique. Avec le département Technique et Compétitivité (TaCIT), dont les ingénieurs logiciel optimisent continuellement les algorithmes métiers de la compagnie. Avec le service des Configurations Techniques (Technical Landscape Services), qui recette et intègre les infrastructures et services HPC afin de garantir les meilleurs niveaux de disponibilité et d’optimisation pour les workflows métier.

Modélisation type d’un réservoir, obtenue après traitement de datasets à la fois volumineux et complexes. On voit sur l’image la simulation de l’implantation des points d’extraction.

C’est en regard de cette coopération multilatérale que les partenariats le monde académique et avec l’industrie se révèlent stratégiques. Les relations qu’entretient Shell avec Intel, par exemple, lui permettent de disposer en priorité des technologies en cours de commercialisation et lui donne une vision opérationnelle de la roadmap du fondeur. En pratique, Shell a ainsi pu monter une sandbox de 256 CPU régulièrement mise à jour avec les Xeon les plus récents. Grâce à elle, les ingénieurs disposent d’un banc de test confortable déboguer pour les dernières itérations applicatives et optimiser à l’avance les charges de travail prioritaires.

Comme de juste, cette coopération au niveau matériel se décline au niveau logiciel. Shell utilisant les compilateurs Intel C++ et Fortran, la MKL et des optimiseurs tels que VTune, un petit groupe d’experts a été mis en place qui diffuse les meilleures pratiques de développement HPC parmi les équipes techniques. Ces efforts d’optimisation ont pu être soutenus directement par Intel, par l’entremise de correspondants techniques travaillant avec Shell aux Etats-Unis et aux Pays-Bas. Régulièrement, des réunions faisant intervenir une quarantaine d’experts Shell et Intel ont lieu pour que soient définis et planifiés les besoins et les capacités techniques des prochaines générations applicatives.

Si l’architecture globale des systèmes HPC de Shell est basée sur des CPU Xeon, cela n’empêche pas la compagnie de maintenir une veille technologique constante. Les dimensions de ratio coût/performances et de TCO global l’amènent ainsi à évaluer régulièrement des solutions alternatives telles que les accélérateurs GPU et les implémentations FPGA. Un cluster combinant CPU Xeon et GPU de dernière génération a ainsi été déployé pour tester de façon intensive les codes de visualisation en cours de développement.

Sous le fond des océans…

Sur le terrain, ces dispositions techniques impactent de façon importante les activités métier de la compagnie. L’équipe de David Schewitz, Directeur de la géophysique et de la gestion de données pour Shell Upstream Americas, en fait l’expérience quotidiennement. Lorsqu’ils partent explorer le fond du Golfe du Mexique, ils utilisent des canons à air comprimé à pénétration profonde, grâce auxquels des impulsions contrôlées sont envoyées dans l’océan. Ces pulsations traversent la “subsurface” et réfractent sur les couches géologiques. Pour les capter, l’équipe déploie des nœuds de capteurs spécifiques sur le fond océanique et enregistre numériquement les temps de parcours et l’amplitude de l’énergie renvoyée. C’est à partir de clusters HPC qu’en sont déduites les cartographies de subsurface – avec un niveau de profondeur atteignant 16 km.

“Dans le Golfe du Mexique“, explique David Schewitz, “nous sommes la plupart du temps dans des prospections très profondes, sous des sels très complexes. Quand on considère que la cible, généralement assez petite, se trouve à 10 km sous la surface de la terre, il est assez prodigieux de pouvoir l’identifier et la cartographier… Sans HPC, des résultats de ce type sont impossibles à obtenir.”

Vue sismique de la “subsurface” du champs Mars situé dans le Golfe du Mexique, au large de la Louisiane. L’image est extraite d’un des environnements de sismique virtuelle de Shell.

Le traitement et le stockage de données sismiques représentent pour leur part des coûts élevés, mais David Schewitz précise que ces coûts ont malgré tout été divisés par 2,5 en dix ans. “Les économies réalisées nous permettent de traiter plus de données, de déployer des nouvelles technologies sismiques, de piloter simultanément plus de projets et de rendre chaque projet plus important et plus dense“, ajoute-t-il.

Les images sismiques plus précises, disponibles grâce à une collecte de données multiazimuts, permettent également des réductions significatives de coûts industriels, grâce notamment au meilleur positionnement des puits, à la réduction du nombre de ces puits et à des taux de récupération supérieurs. Shell a par exemple identifié d’importants gisements à proximité de ses plateformes Mars-Ursa, au Sud de la Louisiane. Mais les cartographier est difficile du fait d’une importante présence de sels. Grâce à ses programmes d’imagerie OBS (Ocean Bottom Survey) par équation d’onde anisotrope – donc grâce aux outils matériels et logiciels HPC dédiés à cette application – le risque d’erreur est sensiblement minimisé, ce qui renforce la rentabilité de l’exploitation. Au point que l’équipe de David Schewitz est aujourd’hui en train de réaliser cinq autres relevés OBS sur huit gisements différents.

Résultats concrets

Grâce à une stratégie HPC proactive, grâce à des améliorations de processus majeures, Shell améliore de façon significative la performance de ses activités à l’échelle internationale. L’équipe TaCIT a ainsi pu tripler les performances de la modélisation de réservoirs Dynamo développée en interne.

Les workflows Dynamo, quant à eux, bénéficient d’un facteur d’accélération encore plus élevé. Les efforts d’optimisation applicative ont produit des gains en efficacité de l’ordre de 2X à 12X, selon le workflow, avec des augmentations de l’ordre de 8X à 60X si l’on prend en compte l’accès à des parcs matériels de plus grande capacité.

Enfin, les ingénieurs de technologie sismique d’IRD et de logiciel sismique de TaCIT ont été en mesure de développer des versions hautes performances des applications métier les plus critiques de la compagnie. Avec pour conséquence un accroissement sensible de la productivité des équipes de terrain et d’analyse.

© HPC Today 2024 - All rights reserved.

Thank you for reading HPC Today.